搜索结果: 1-15 共查到“人工智能 芯片”相关记录38条 . 查询时间(0.109 秒)

中国科学院自动化所研发脉冲动态计算的毫瓦级超低功耗异步感算一体类脑芯片(图)

计算 神经网络 软件

2024/6/29

人脑能够运行非常复杂且庞大的神经网络,总功耗却仅为20瓦,远小于现有的人工智能系统。因此,在算力比拼加速,能耗日益攀升的今日,借鉴人脑的低功耗特性发展新型智能计算系统成为极具潜力的方向。

中华人民共和国科学技术部美国开发出一种新型高精度模拟芯片架构

电子元件 人工智能

2024/9/5

美国南加州大学研究团队开发出一种基于忆阻器的新型高精度模拟芯片架构,旨在结合数字计算的精度和模拟计算的节能和高速优势。忆阻器(memristor)是一种被动电子元件,如同电阻器能产生并维持一股安全的电流通过某个装置。通过调整忆阻器参数,研究团队实现了前所未有的调节精度,并设计出一种新的电路和架构,使得模拟设备的编程更加快速和精确。这种创新不仅适用于神经网络等传统低精度领域,还可扩展至其他存储技术领...

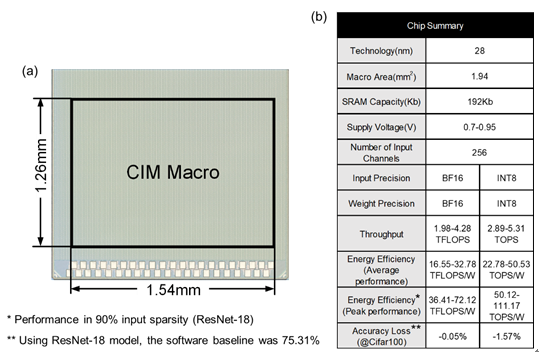

中国科学院微电子所在数模混合存算一体芯片方面取得重要进展(图)

芯片 智能计算

2024/2/28

当前,基于边缘智能计算设备运行的人工智能应用日趋复杂及高精度,为降低边缘设备运行的延迟和功耗,存算一体技术被应用在边缘设备端,通过减小数据搬运的开销最大化减少边缘设备上的延迟与功耗。但传统的存算一体宏仅支持使用整数型数据计算,难以支持日趋高精度、高复杂度以及片上训练的边缘端智能计算任务。且仅使用单一模拟或数字方案的存算一体宏,在能量效率、面积效率和精度上难以取得最优化。如何有效结合模拟存算与数字存...

中国科学院微电子所在片上学习存算一体芯片方面取得重要进展(图)

一体芯片 神经网络 智能计算

2024/2/28

当前,智能计算设备呈指数式增长,迫切需要低功耗与低延迟执行神经网络推理任务,以及不依赖云端的片上学习能力来动态适应边缘端复杂多变的应用场景。非易失存算一体技术可最大化减少数据搬运带来的功耗和延迟并消除静态功耗,为边缘智能计算设备提供了一种极具竞争力的方案。非易失存算一体芯片近年来持续快速发展,其在集成规模、能效、算力等方面均取得了长足的进步,实现了对片上推理任务的高效支持。但进行片上学习通常需要对...

中国科学院半导体所在脉冲型人工视觉芯片研制取得新进展(图)

芯片研制 智能感知系统 图像传感器

2024/2/28

人工视觉芯片是一种感算一体化的图像传感器,能够单芯片完成图像获取和原位实时智能图像处理等任务,是一种典型的边端型智能感知系统芯片。它可以被广泛应用于自动驾驶、敏捷机器人、智能无人机、混合现实和工业机器视觉等前沿邻域。目前的人工视觉芯片以多比特实数数据形式在片上进行图像信息的获取、表达、处理和传输,面临处理数据量大、深度神经网络计算复杂度高、电路复杂、片上存储开销大、处理延迟和功耗大等诸多的设计和应...

中国科学院合肥物质科研团队利用3D视觉测量技术助力国产芯片外观检测(图)

3D视觉测量 国产芯片 外观检测 仿生智能

2023/7/24

2022年3月16日,中科院合肥研究院智能所仿生智能中心在自主开发的软件平台上实现了3D视觉测量技术、视觉缺陷检测等技术的完美融合,解决了国内首款国产GPU——凌久GP102的外观检测问题。目前首台具有自主知识产权的BGA芯片外观检测设备已正式交付并通过验收。

人工智能将加速计算机芯片设计

计算机芯片 人工智能 芯片布局

2022/3/17

《自然》近日发表的一篇来自谷歌研究院研究人员的论文指出,机器学习工具可以极大地加速计算机芯片设计。研究显示,该方法能给出可行的芯片设计,且芯片性能不亚于人类工程师的设计;而整个设计过程只要几个小时,而不是几个月。这种方法已经被谷歌公司用来设计下一代人工智能计算机系统。

神经网络完成芯片设计仅需几小时 已被用来设计下一代人工智能计算机系统

神经网络 芯片设计 人工智能 计算机系统

2021/6/29

英国《自然》杂志9日发表一项人工智能突破性成就,美国科学家团队报告机器学习工具已可以极大地加速计算机芯片设计。研究显示,该方法能给出可行的芯片设计,且芯片性能不亚于人类工程师的设计,而整个设计过程只要几个小时,而不是几个月,这为今后的每一代计算机芯片设计节省数千小时的人力。这种方法已经被谷歌用来设计下一代人工智能计算机系统。

南方科技大学深港微电子学院余浩教授获第十届吴文俊人工智能专项奖(芯片项目)二等奖并主持边缘智能芯片设计新进展前沿论坛

南方科技大学深港微电子学院 余浩 第十届 吴文俊人工智能专项奖 芯片项目 边缘智能芯片设计 论坛

2022/10/18

东南大学国家ASIC中心单伟伟、杨军团队在ISSCC 2020发表AI芯片亮点论文

东南大学国家ASIC中心 单伟伟 杨军 ISSCC 2020 IEEE国际固态电路峰会 AI芯片 人工智能

2022/5/7